# [神经网络计算异或]()

首先介绍

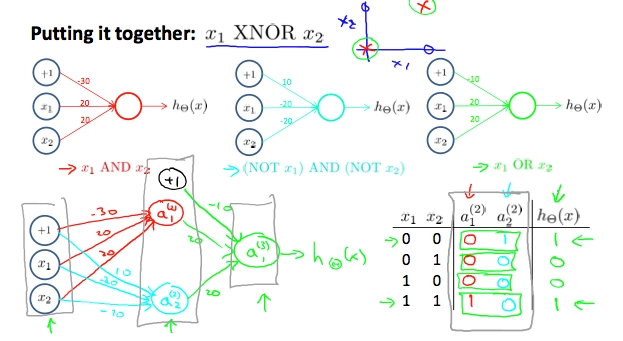

## 1、“和”操作:

x1, x2 ∈ {0, 1}

y = x1 AND x2

有

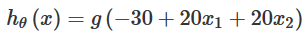

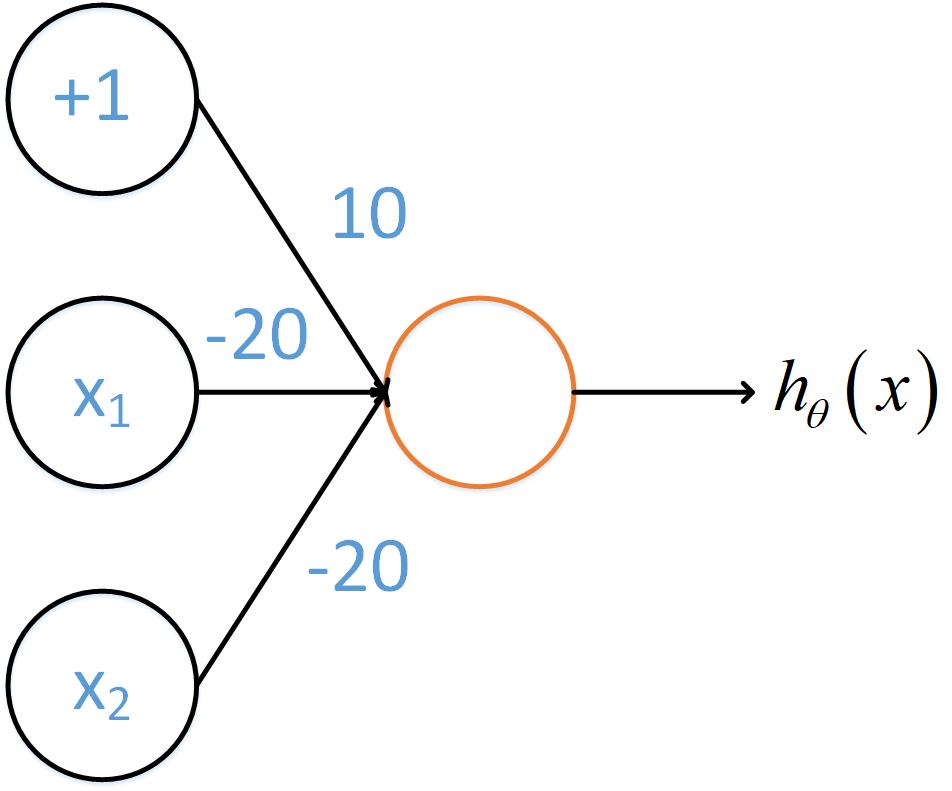

hθ(x)\=g(−30+20x1+20x2)

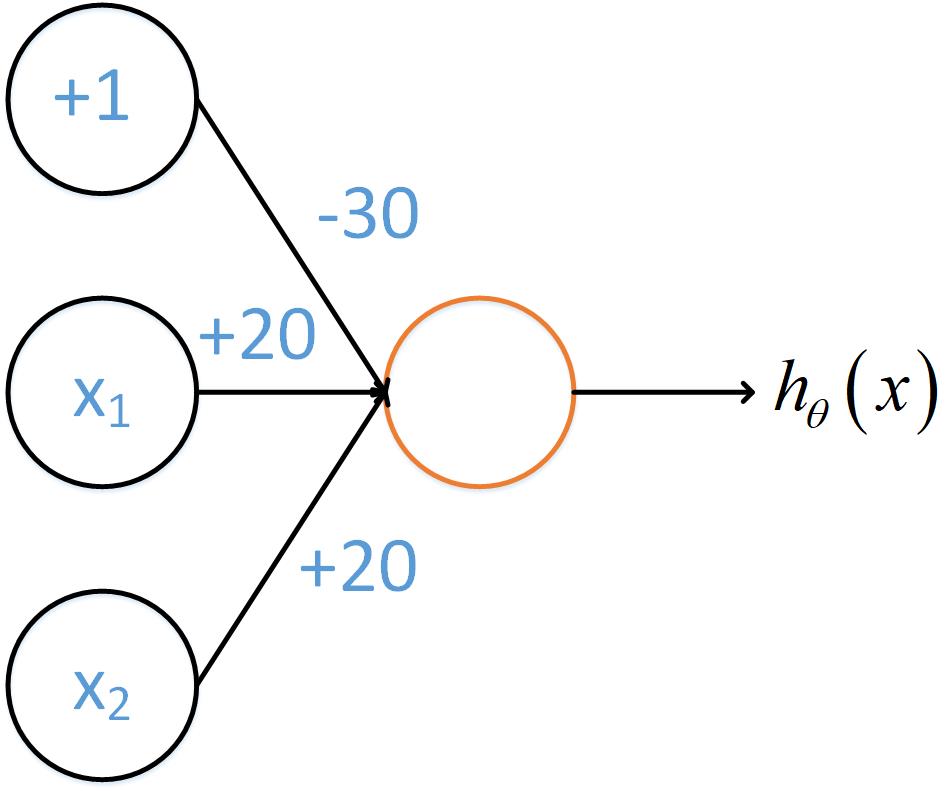

其中g()是sigmoid函数,其图示如下

当z=4.6时,函数值约为0.99;当z=-4.6时,函数值约为0.01

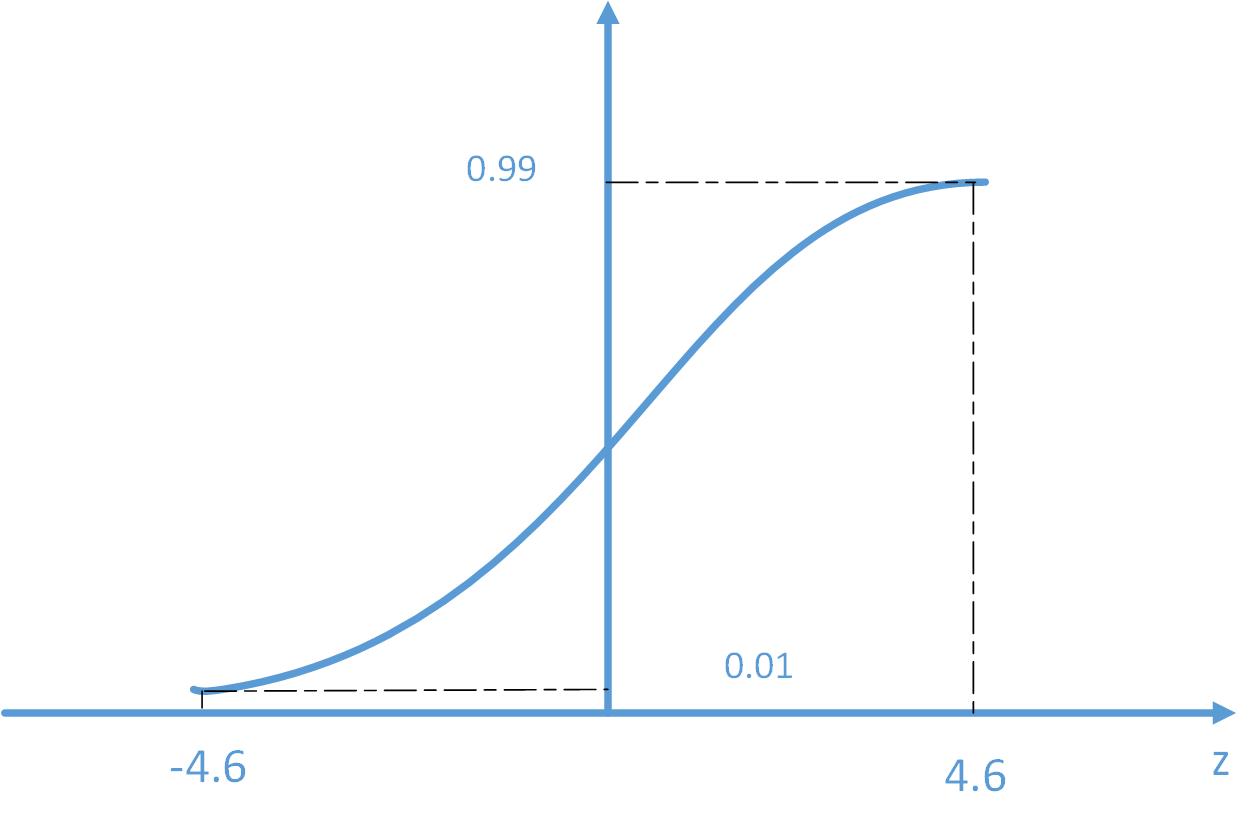

计算

x1x2h(x)00g(-30)≈001g(-10)≈010g(-10)≈011g(10)≈1

然后是

## 2、“或”操作

有

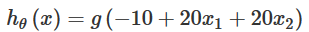

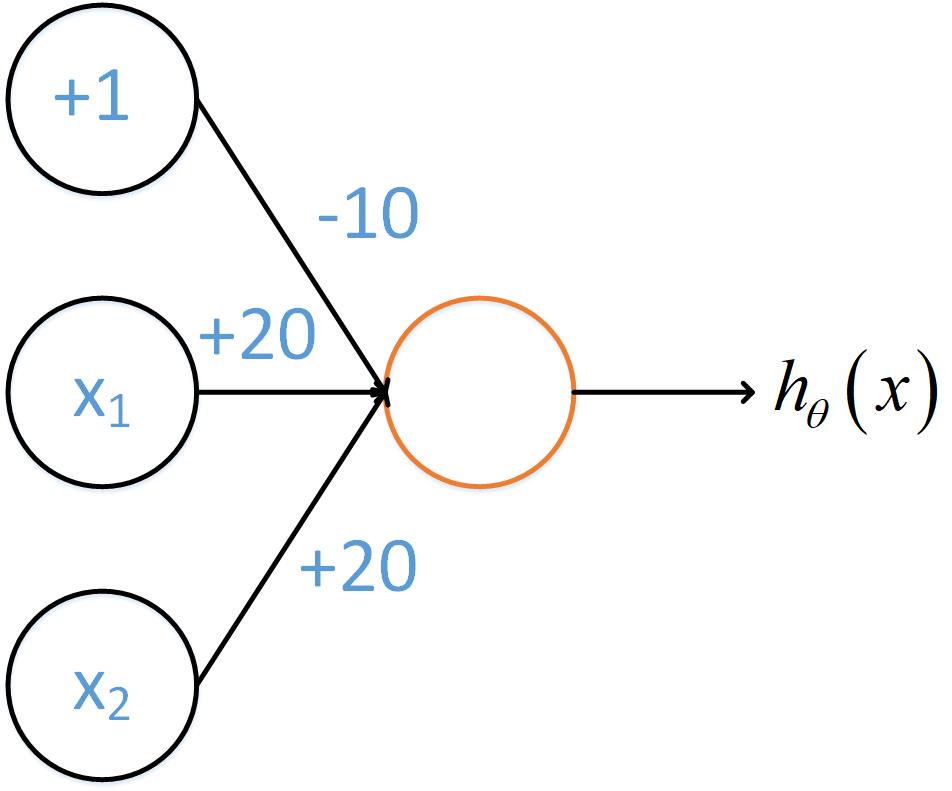

hθ(x)\=g(−10+20x1+20x2)

x1x2h(x)000011101111

然后是

## 3、“非”操作

有

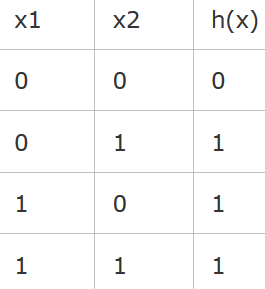

hθ(x)\=g(10−20x1)

计算

x1h(x)0110

(当 x==0时, h(x)==1; 当 x==1时,h(x)==0;不用解释)。

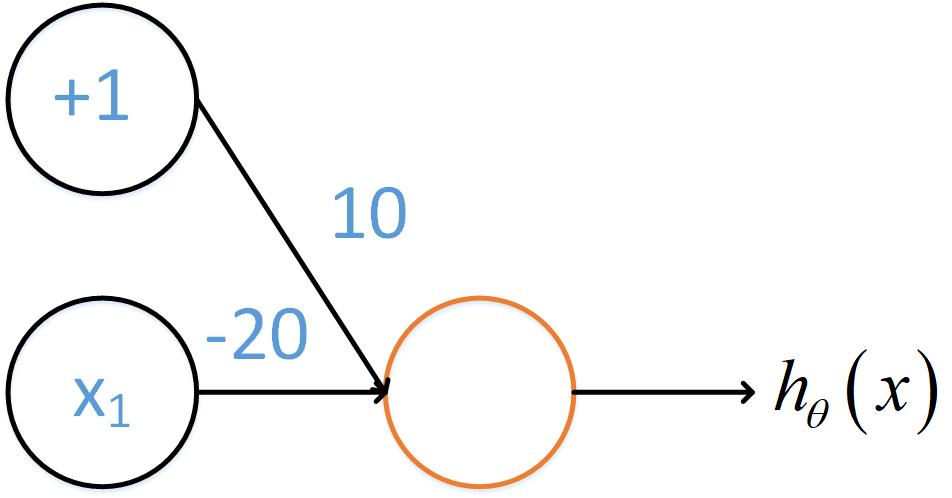

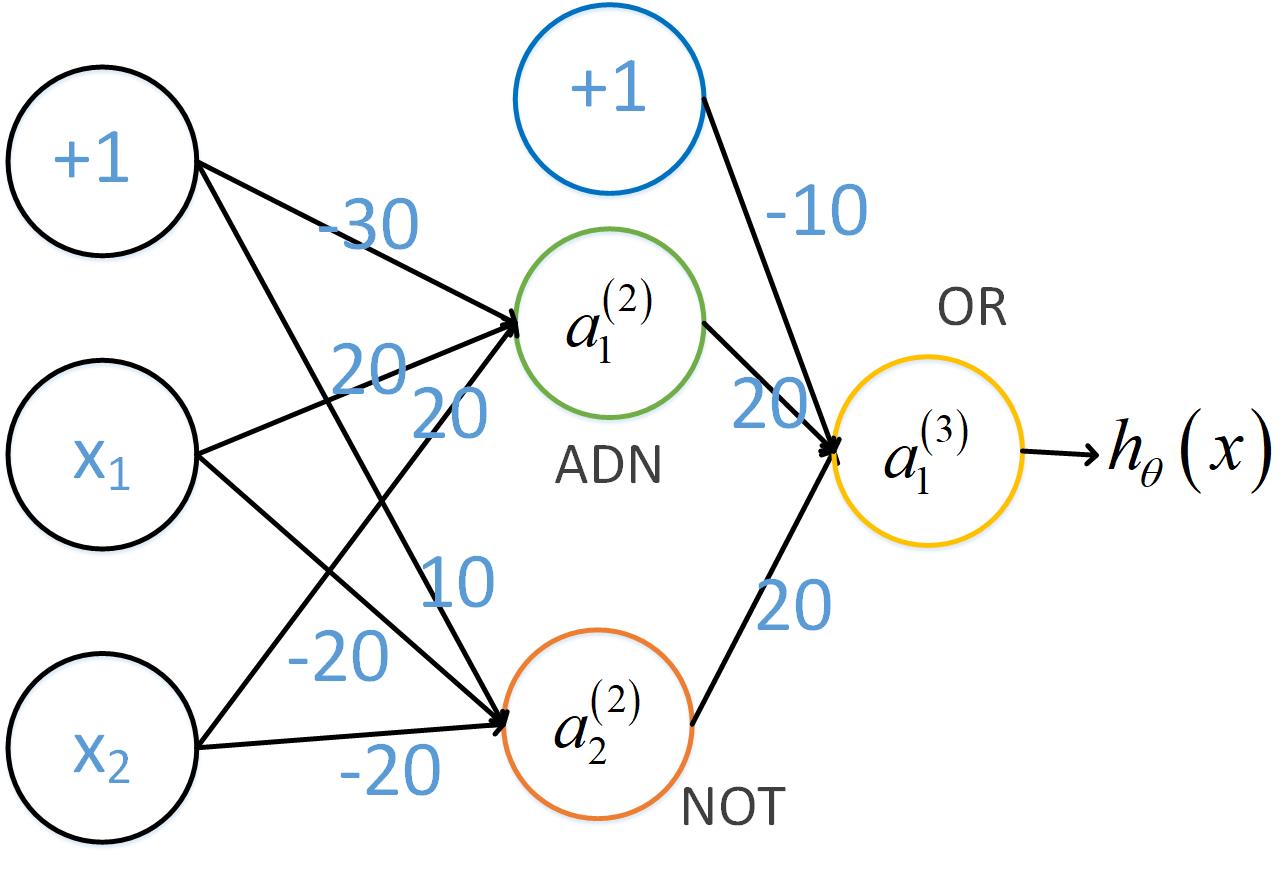

那么“非x1和非x2”如下图

* * *

## 4、最后计算“异或”

计算

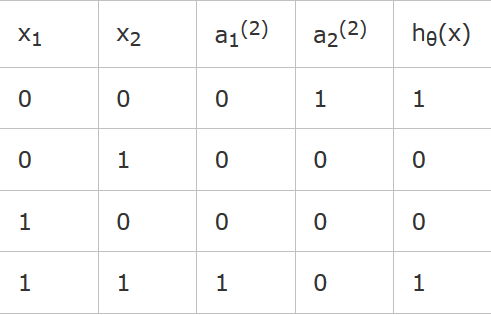

x1x2a1(2)a2(2)hθ(x)00011010001000011101

*

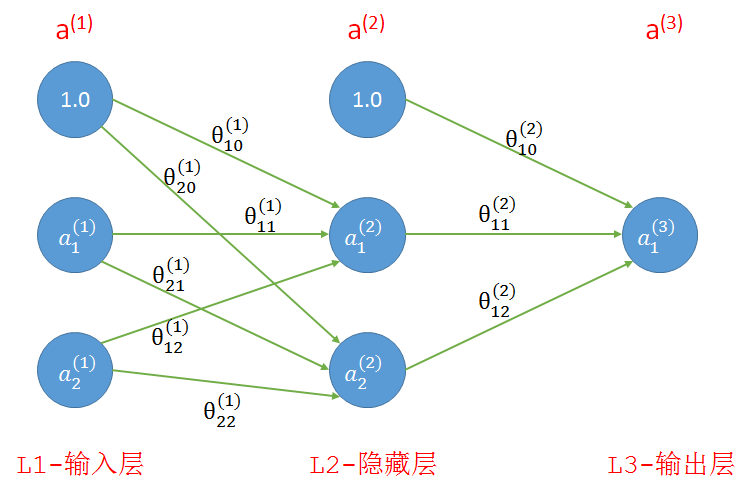

如果算上输入层我们的网络共有三层,如下图所示,其中第1层和第2层中的1分别是这两层的偏置单元。连线上是连接前后层的参数。

* 输入:我们一共有四个训练样本,每个样本有两个特征,分别是(0, 0), (1, 0), (0, 1), (1, 1);

* 理想输出:参考上面的真值表,样本中两个特征相同时为0,相异为1

* 参数:随机初始化,范围为(-1, 1)

*

## 5、“同或”,并且总结:

分类: [machine learning 相关](https://www.cnblogs.com/qkloveslife/category/1319459.html)

- BP神经网络到c++实现等--机器学习“掐死教程”

- 训练bp(神经)网络学会“乘法”--用”蚊子“训练高射炮

- Ann计算异或&前馈神经网络20200302

- 神经网络ANN的表示20200312

- 简单神经网络的后向传播(Backpropagration, BP)算法

- 牛顿迭代法求局部最优(解)20200310

- ubuntu安装numpy和pip3等

- 从零实现一个神经网络-numpy篇01

- _美国普林斯顿大学VictorZhou神经网络神文的改进和翻译20200311

- c语言-普林斯顿victorZhou神经网络实现210301

- bp网络实现xor异或的C语言实现202102

- bp网络实现xor异或-自动录入输入(写死20210202

- Mnist在python3.6上跑tensorFlow2.0一步一坑20210210

- numpy手写数字识别-直接用bp网络识别210201